Vendosni modele Qwen me importin e modelit me porosi Amazon Bedrock

Jemi të ngazëllyer të njoftojmë se importi i modelit me porosi Amazon Bedrock tani mbështet modelet Qwen. Tani mund të importoni pesha të personalizuara për arkitekturat QWEN2, QWEN2_VL dhe QWEN2_5_VL, duke përfshirë modele si Coder Qwen 2, 2.5, QWEN 2.5 VL, dhe QWQ 32B. Ju mund të sillni modelet tuaja të personalizuara QWEN në Amazon Bedrock dhe t’i vendosni ato në një mjedis plotësisht të menaxhuar, pa server – pa pasur nevojë për të menaxhuar infrastrukturën ose modelin e shërbimit.

Në këtë post, ne mbulojmë se si të vendosim modele QWEN 2.5 me importin e modelit me porosi Amazon Bedrock, duke i bërë ato të arritshme për organizatat që kërkojnë të përdorin aftësi më të mira të AI brenda infrastrukturës AWS me një kosto efektive.

Pasqyrë e modeleve Qwen

Qwen 2 dhe 2.5 janë familje të modeleve të gjuhëve të mëdha, të disponueshme në një gamë të gjerë të madhësive dhe varianteve të specializuara që i përshtaten nevojave të ndryshme:

- Modele të përgjithshme të gjuhës: Modelet që variojnë nga parametrat 0.5B deri në 72B, me të dy versionet bazë dhe udhëzuese për detyrat me qëllime të përgjithshme

- Qwen 2.5-kodues: E specializuar për gjenerimin dhe përfundimin e kodit

- QWEN 2.5-MATH: I përqendruar në arsyetimin e përparuar matematikor

- Qwen 2.5-VL (gjuha e vizionit): Aftësitë e përpunimit të figurës dhe videos, duke mundësuar aplikime multimodale

Pasqyrë e importit të modelit me porosi Amazon Bedrock

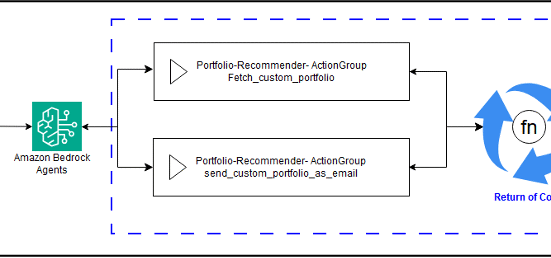

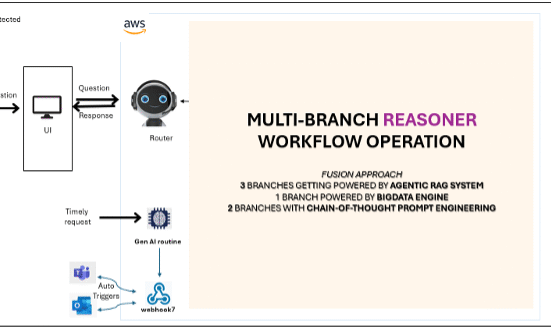

Importi i modelit me porosi Amazon Bedrock mundëson importin dhe përdorimin e modeleve tuaja të personalizuara së bashku me modelet ekzistuese të fondacionit (FMS) përmes një API të vetëm pa server, të unifikuar. Ju mund të hyni në modelet tuaja të importuara me porosi sipas kërkesës dhe pa pasur nevojë të menaxhoni infrastrukturën themelore. Përshpejtoni zhvillimin tuaj gjenerues të aplikacionit AI duke integruar modelet tuaja me porosi të mbështetura me mjete vendase të amazonës në amazon dhe karakteristika si bazat e njohurive në amazon në shtrat, rojet e shtratit të Amazon dhe agjentët e amazonës. Importi i modelit me porosi Amazon Bedrock është përgjithësisht i disponueshëm në rajonet AWS të SHBA-East (N. Virginia), US-West (Oregon) dhe Evropë (Frankfurt). Tani, ne do të shqyrtojmë se si mund të përdorni modele QWEN 2.5 për dy raste të përdorimit të zakonshëm: si asistent kodimi dhe për të kuptuar imazhin. Qwen2.5-koder është një model i kodit më të lartë, aftësi që përputhen me modelet e pronarit si GPT-4O. Mbështet mbi 90 gjuhë programimi dhe shkëlqen në gjenerimin e kodeve, debugging dhe arsyetimin. Qwen 2.5-VL sjell aftësi të përparuara multimodale. Sipas Qwen, Qwen 2.5-VL nuk është vetëm i aftë në njohjen e objekteve të tilla si lulet dhe kafshët, por edhe në analizën e tabelave, nxjerrjen e tekstit nga imazhet, interpretimin e paraqitjeve të dokumenteve dhe përpunimin e videove të gjata.

Parakushte

Para se të importoni modelin Qwen me importin e modelit me porosi Amazon Bedrock, sigurohuni që të keni sa vijon në vend:

- Një llogari aktive AWS

- Një kovë e shërbimit të thjeshtë për ruajtjen e Amazon (Amazon S3) për të ruajtur skedarët e modelit Qwen

- Leje të mjaftueshme për të krijuar punë të importit të modelit të shtratit Amazon

- Verifikuar që rajoni juaj mbështet importin e modelit me porosi Amazon Bedrock

Përdorni rastin 1: Asistent i Kodimit Qwen

Në këtë shembull, ne do të demonstrojmë se si të ndërtojmë një asistent kodimi duke përdorur modelin QWEN2.5-kodues-7b-instrukt

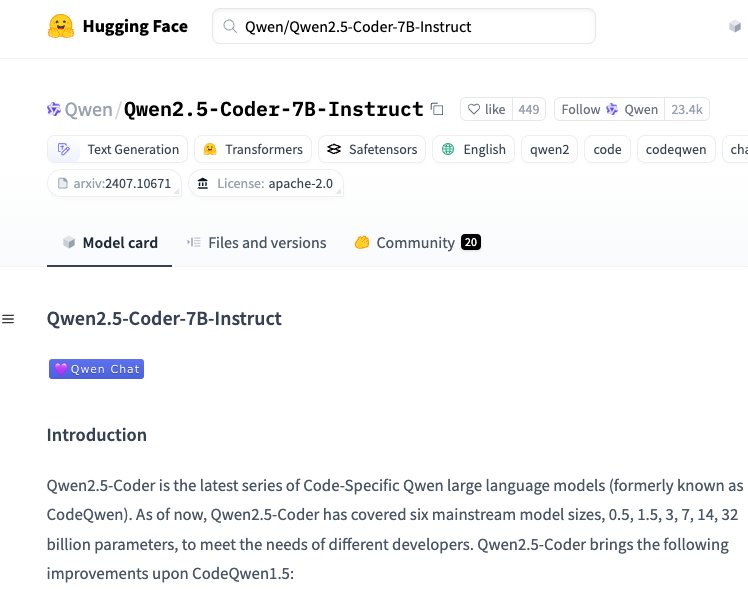

- Shkoni te përqafimi i fytyrës dhe kërkoni dhe kopjoni ID-në e modelit Qwen/Qwen2.5-Coder-7b-instrukt:

Ju do të përdorni Qwen/Qwen2.5-Coder-7B-Instruct Për pjesën tjetër të përparimit. Ne nuk demonstrojmë hapa të rregullimit të mirë, por ju gjithashtu mund të rregulloni mirë përpara se të importoni.

- Përdorni komandën e mëposhtme për të shkarkuar një fotografi të modelit në vend. Biblioteka Python për Hugging Face ofron një mjet të quajtur Snapshot Shkarkim për këtë:

Në varësi të madhësisë së modelit tuaj, kjo mund të zgjasë disa minuta. Kur të përfundojë, dosja juaj e modelit Coder Coder 7B do të përmbajë skedarët e mëposhtëm.

- Skedarët e konfigurimit: Përfshirë

config.json,generation_config.json,tokenizer_config.json,tokenizer.jsondhevocab.json - Skedarët e modelit: Katër

safetensorskedarët dhemodel.safetensors.index.json - Dokumentim:

LICENSE,README.mddhemerges.txt

- Ngarkoni modelin në Amazon S3, duke përdorur

boto3ose linja e komandës:

aws s3 cp ./extractedfolder s3://yourbucket/path/ --recursive

- Filloni punën e modelit të importit duke përdorur thirrjen e mëposhtme API:

Ju gjithashtu mund ta bëni këtë duke përdorur tastierën e menaxhimit AWS për shtratin e Amazon.

- Në tastierën e Bedrock Amazon, zgjidhni Modele të importuara në panelin e lundrimit.

- Zgjedh Importoni një model.

- Shkruani detajet, përfshirë një Emrin e modelit, Importoni emrin e punësdhe modeli Vendndodhja S3.

- Krijoni një rol të ri shërbimi ose përdorni një rol ekzistues të shërbimit. Pastaj zgjidhni modelin e importit

- Pasi të zgjidhni Importoj Në tastierë, ju duhet ta shihni statusin si import kur modeli po importohet:

Nëse jeni duke përdorur rolin tuaj, sigurohuni që të shtoni marrëdhënien e mëposhtme të besimit siç përshkruan në krijimin e një rol shërbimi për importin e modelit.

Pasi të importohet modeli juaj, prisni që konkluzioni i modelit të jetë gati, dhe pastaj bisedoni me modelin në shesh lojërash ose përmes API. Në shembullin vijues, ne shtojmë Python Për të nxitur modelin që të dalë drejtpërdrejt në kodin Python për të renditur artikujt në një kovë S3. Mos harroni të përdorni modelin e duhur të bisedës për të futur kërkesa në formatin e kërkuar. Për shembull, ju mund të merrni modelin e duhur të bisedës për çdo model të pajtueshëm në fytyrën e përqafimit duke përdorur kodin më poshtë:

Vini re se kur përdorni invoke_model API, ju duhet të përdorni emrin e plotë të burimit Amazon (ARN) për modelin e importuar. Ju mund ta gjeni modelin ARN në tastierën e shtratit, duke lundruar në seksionin e modeleve të importuara dhe më pas duke parë faqen e detajeve të modelit, siç tregohet në figurën e mëposhtme

Pasi modeli të jetë gati për konkluzion, mund të përdorni shesh lojërash chat në tastierën e shtratit ose API për të thirrur modelin.

Përdorni rastin 2: Qwen 2.5 VL Kuptimi i imazhit

QWEN2.5-VL-* ofron aftësi multimodale, duke kombinuar vizionin dhe të kuptuarit e gjuhës në një model të vetëm. Ky seksion demonstron se si të vendosni QWEN2.5-VL duke përdorur importin e modelit me porosi Amazon Bedrock dhe të testoni aftësitë e tij të mirëkuptimit të imazhit.

Importoni QWEN2.5-VL-7B në Amazon Bedrock

Shkarkoni modelin nga HuggingFace Face dhe ngarkojeni atë në Amazon S3:

Tjetra, importoni modelin në Amazon Bedrock (qoftë përmes tastierës ose API):

Testoni aftësitë e vizionit

Pasi të përfundojë importi, provoni modelin me një hyrje të imazhit. Modeli QWEN2.5-VL-* kërkon formatimin e duhur të inputeve multimodale:

Kur pajiset me një imazh shembull të një mace (siç është imazhi i mëposhtëm), modeli përshkruan me saktësi tiparet kryesore siç janë pozicioni i maceve, ngjyra e leshit, ngjyra e syve dhe pamja e përgjithshme. Kjo demonstron aftësinë e modelit QWEN2.5-VL-* për të përpunuar informacionin vizual dhe për të gjeneruar përshkrime përkatëse të tekstit.

Përgjigja e modelit:

Çmim

Ju mund të përdorni importin e modelit me porosi Amazon Bedrock për të përdorur peshat e modelit tuaj të personalizuar brenda Bedrock Amazon për arkitekturat e mbështetura, duke i shërbyer ato së bashku me Amazon Bedrock të pritur FMS në një mënyrë të menaxhuar plotësisht përmes modalitetit të kërkesës. Importi i modelit me porosi nuk ngarkon për importin e modelit. Ju ngarkoheni për konkluzion bazuar në dy faktorë: numrin e kopjeve të modelit aktiv dhe kohëzgjatjen e tyre të aktivitetit. Faturimi ndodh në rritje 5-minutëshe, duke filluar nga thirrja e parë e suksesshme e secilës kopje model. Icingmimi për një kopje model për minutë ndryshon bazuar në faktorë përfshirë arkitekturën, gjatësinë e kontekstit, rajonin dhe versionin e njësisë së llogaritjes, dhe vlerësohet nga madhësia e kopjimit të modelit. Modeli i personalizuar bashkimet e kërkuara për pritjen varet nga arkitektura e modelit, numërimi i parametrave dhe gjatësia e kontekstit. Amazon Bedrock automatikisht menaxhon shkallëzimin bazuar në modelet tuaja të përdorimit. Nëse nuk ka thirrje për 5 minuta, ajo peshon në zero dhe peshon kur është e nevojshme, megjithëse kjo mund të përfshijë vonesë të fillimit të ftohtë deri në një minutë. Kopje shtesë shtohen nëse vëllimi i konkluzionit tejkalon në mënyrë të vazhdueshme kufijtë e njëkohshëm të njëtrajtshmërisë. Prodhimi maksimal dhe pajtueshmëria për kopje përcaktohet gjatë importit, bazuar në faktorë të tillë si përzierja e shenjës hyrëse/dalje, lloji i pajisjes, madhësia e modelit, arkitektura dhe optimizimet e konkluzionit.

Për më shumë informacion, shihni çmimet e Amazon Bedrock.

Pastroj

Për të shmangur tarifat e vazhdueshme pas përfundimit të eksperimenteve:

- Fshini modelet tuaja të importuara QWEN nga importi i modelit me porosi Amazon Bedrock duke përdorur tastierën ose API.

- Opsionale, fshini skedarët e modelit nga kova juaj S3 nëse nuk keni më nevojë për to.

Mos harroni se ndërsa importi i modelit me porosi Amazon Bedrock nuk ngarkon vetë procesin e importit, ju jeni të faturuar për përdorimin dhe ruajtjen e konkluzionit të modelit.

Përfundim

Modeli me porosi Amazon Bedrock Importi i importit fuqizon organizatat të përdorin modele të fuqishme të disponueshme publik si QWEN 2.5, ndër të tjera, ndërsa përfitojnë nga infrastruktura e klasës së ndërmarrjeve. Natyra pa server e Amazon Bedrock eliminon kompleksitetin e menaxhimit të vendosjeve dhe operacioneve të modelit, duke lejuar ekipet të përqëndrohen në ndërtimin e aplikacioneve sesa në infrastrukturë. Me karakteristika si shkallëzimi automatik, çmimi i përdorimit të pagave dhe integrimi i qetë me shërbimet AWS, Amazon Bedrock ofron një mjedis të gatshëm për prodhim për ngarkesat e punës të AI. Kombinimi i aftësive të përparuara të AI të Qwen 2.5 dhe infrastrukturës së menaxhuar të Amazon Bedrock ofron një ekuilibër optimal të performancës, kostos dhe efikasitetit operacional. Organizatat mund të fillojnë me modele më të vogla dhe të shkallëzojnë sipas nevojës, duke ruajtur kontrollin e plotë mbi vendosjet e modelit të tyre dhe të përfitojnë nga aftësitë e sigurisë dhe pajtueshmërisë AWS.

Për më shumë informacion, referojuni Udhëzuesit të Përdoruesit të Amazon Bedrock.

Rreth autorëve

Ajit Mahareddy është një produkt me përvojë dhe drejtues i tregut (GTM) me mbi 20 vjet përvojë në menaxhimin e produkteve, inxhinierinë dhe të shkojë në treg. Para rolit të tij aktual, Ajit drejtoi ndërtimin e produkteve të produkteve AI/ML në kompanitë kryesore të teknologjisë, duke përfshirë Uber, Turing dhe EHealth. Ai është i apasionuar pas avancimit të teknologjive gjeneruese të AI dhe drejtimit të ndikimit të botës reale me AI gjeneruese.

Ajit Mahareddy është një produkt me përvojë dhe drejtues i tregut (GTM) me mbi 20 vjet përvojë në menaxhimin e produkteve, inxhinierinë dhe të shkojë në treg. Para rolit të tij aktual, Ajit drejtoi ndërtimin e produkteve të produkteve AI/ML në kompanitë kryesore të teknologjisë, duke përfshirë Uber, Turing dhe EHealth. Ai është i apasionuar pas avancimit të teknologjive gjeneruese të AI dhe drejtimit të ndikimit të botës reale me AI gjeneruese.

Shreyas Subramanian është një shkencëtar kryesor i të dhënave dhe ndihmon klientët duke përdorur AI gjeneruese dhe mësim të thellë për të zgjidhur sfidat e tyre të biznesit duke përdorur shërbime AWS. Shreyas ka një sfond në optimizimin në shkallë të gjerë dhe ML dhe në përdorimin e ML dhe mësimit të përforcimit për përshpejtimin e detyrave të optimizmit.

Shreyas Subramanian është një shkencëtar kryesor i të dhënave dhe ndihmon klientët duke përdorur AI gjeneruese dhe mësim të thellë për të zgjidhur sfidat e tyre të biznesit duke përdorur shërbime AWS. Shreyas ka një sfond në optimizimin në shkallë të gjerë dhe ML dhe në përdorimin e ML dhe mësimit të përforcimit për përshpejtimin e detyrave të optimizmit.

Yanyan Zhang është një shkencëtar i lartë gjenerues i të dhënave të AI në Amazon Web Services, ku ajo ka punuar në teknologjitë e përparme të AI/ML si një specialist gjenerues i AI, duke ndihmuar klientët të përdorin AI gjeneruese për të arritur rezultatet e tyre të dëshiruara. Yanyan u diplomua në Universitetin A&M të Teksasit me një doktoraturë në inxhinieri elektrike. Jashtë punës, ajo pëlqen të udhëtojë, të punojë jashtë dhe të eksplorojë gjëra të reja.

Yanyan Zhang është një shkencëtar i lartë gjenerues i të dhënave të AI në Amazon Web Services, ku ajo ka punuar në teknologjitë e përparme të AI/ML si një specialist gjenerues i AI, duke ndihmuar klientët të përdorin AI gjeneruese për të arritur rezultatet e tyre të dëshiruara. Yanyan u diplomua në Universitetin A&M të Teksasit me një doktoraturë në inxhinieri elektrike. Jashtë punës, ajo pëlqen të udhëtojë, të punojë jashtë dhe të eksplorojë gjëra të reja.

Dharinee Gupta është një menaxher inxhinierik në AWS Bedrock, ku ajo përqendrohet në mundësimin e klientëve që të përdorin pa probleme modelet me burim të hapur përmes zgjidhjeve pa server. Ekipi i saj specializohet në optimizimin e këtyre modeleve për të ofruar bilancin më të mirë të performancës së kostos për klientët. Para rolit të saj aktual, ajo fitoi përvojë të gjerë në sistemet e vërtetimit dhe autorizimit në Amazon, duke zhvilluar zgjidhje të sigurta për qasje për ofertat në Amazon. Dharinee është e apasionuar pas bërjes së teknologjive të përparuara të AI të arritshme dhe efikase për klientët AWS.

Dharinee Gupta është një menaxher inxhinierik në AWS Bedrock, ku ajo përqendrohet në mundësimin e klientëve që të përdorin pa probleme modelet me burim të hapur përmes zgjidhjeve pa server. Ekipi i saj specializohet në optimizimin e këtyre modeleve për të ofruar bilancin më të mirë të performancës së kostos për klientët. Para rolit të saj aktual, ajo fitoi përvojë të gjerë në sistemet e vërtetimit dhe autorizimit në Amazon, duke zhvilluar zgjidhje të sigurta për qasje për ofertat në Amazon. Dharinee është e apasionuar pas bërjes së teknologjive të përparuara të AI të arritshme dhe efikase për klientët AWS.

Lokeshwaran Ravi është një inxhinier i lartë i përpiluesit të mësimit të thellë në AWS, i specializuar në optimizimin e ML, përshpejtimin e modelit dhe sigurinë e AI. Ai përqendrohet në rritjen e efikasitetit, uljen e kostove dhe ndërtimin e ekosistemeve të sigurta për të demokratizuar teknologjitë e AI, duke e bërë ML të arritshme dhe me ndikim në industri.

Lokeshwaran Ravi është një inxhinier i lartë i përpiluesit të mësimit të thellë në AWS, i specializuar në optimizimin e ML, përshpejtimin e modelit dhe sigurinë e AI. Ai përqendrohet në rritjen e efikasitetit, uljen e kostove dhe ndërtimin e ekosistemeve të sigurta për të demokratizuar teknologjitë e AI, duke e bërë ML të arritshme dhe me ndikim në industri.

Qershori Fitoi është një menaxher kryesor i produktit me Amazon Sagemaker Jumpstart. Ai përqendrohet në bërjen e modeleve të fondacionit lehtësisht të zbulueshme dhe të përdorshme për të ndihmuar klientët të ndërtojnë aplikacione gjeneruese të AI. Përvoja e tij në Amazon gjithashtu përfshin aplikacione për blerje celulare dhe shpërndarjen e fundit të miljeve.

Qershori Fitoi është një menaxher kryesor i produktit me Amazon Sagemaker Jumpstart. Ai përqendrohet në bërjen e modeleve të fondacionit lehtësisht të zbulueshme dhe të përdorshme për të ndihmuar klientët të ndërtojnë aplikacione gjeneruese të AI. Përvoja e tij në Amazon gjithashtu përfshin aplikacione për blerje celulare dhe shpërndarjen e fundit të miljeve.

Leave feedback about this